Cat-1

Cat-2

Cat-2

Cat-1

Cat-1

Cat-2

Cat-2

Asteroides

Cometas

Label: Física

Solo un 5% de nuestro

universo está constituido por materia ‘ordinaria’, la que supuestamente

conocemos, pero incluso este pequeño porcentaje es difícil de rastrear.

Hace décadas que los astrónomos buscan donde se esconden en el cosmos

más de la mitad de los bariones, partículas como los neutrones y

protones, y con la ayuda del observatorio espacial XMM-Newton de rayos X

los han encontrado: en el ardiente gas intergaláctico.

Las misteriosas energía y materia oscuras constituyen, respectivamente, el 70% y el 25% del universo. El resto, la materia común que compone todo lo que vemos, desde las estrellas y galaxias hasta los planetas y nosotros mismos, representa tan solo un 5%.

Los astrónomos han calculado que ese es el porcentaje de materia ordinaria, formada básicamente por bariones (partículas con tres quarks como los neutrones y protones), a partir de las observaciones del fondo cósmico de microondas, la luz más antigua en la historia del cosmos originada unos 380.000 años después del Big Bang.

Las observaciones de galaxias muy distantes permiten seguir la evolución de esta materia durante el primer par de miles de millones de años del universo. Sin embargo, justo después más de la mitad desaparece.

Se estima que las estrellas y el gas interestelar frío –su materia prima– que impregna las galaxias no alcanzan el 10% de la materia común. Sumando el gas caliente difuso de los halos que rodean las galaxias y el todavía más caliente que rellena los cúmulos galácticos –las estructuras cósmicas más grandes que se mantienen unidas por la gravedad–, el porcentaje no llega al 20%.

Esta pequeña proporción no debe sorprender. Las estrellas, galaxias y los cúmulos galácticos se forman en los nudos más densos de la red cósmica, ese entramado de filamentos de materia oscura y ordinaria que se extiende por todo el universo. Aunque estas zonas son densas, también son raras, por lo que no son los mejores sitios para encontrar la mayor parte de la materia cósmica.

En busca de los bariones perdidos

Los astrónomos pensaron entonces que los bariones ‘desaparecidos’ debían estar en los ubicuos filamentos de la red cósmica, donde, sin embargo, la materia es menos densa, y por tanto, más difícil de observar. Utilizando diferentes técnicas, pudieron localizar una buena porción de este material intergaláctico, principalmente sus componentes fríos y cálido (gas a cientos de miles de grados), elevando el porcentaje total a un respetable 60%, pero dejando el misterio general sin resolver. ¿Dónde está el otro 40%?

Fabrizio y muchos otros astrónomos de todo el mundo han seguido las huellas de los bariones restantes durante casi dos décadas, desde que los observatorios de rayos X como XMM-Newton de la Agencia Espacial Europea (ESA) y Chandra de la NASA se pusieron a disposición de la comunidad científica.

Observando en esa franja del espectro electromagnético, fue cuando pudieron detectar gas intergaláctico realmente caliente, con temperaturas de alrededor de un millón de grados o más, que estaba bloqueando los rayos X emitidos por fuentes aún más distantes.

Para este estudio, los autores utilizaron XMM-Newton para observar un cuásar, una galaxia masiva con un agujero negro supermasivo en su centro que devora activamente materia y brilla intensamente desde los rayos X hasta las ondas de radio. Analizaron este cuásar, cuya luz tarda más de 4.000 millones de años en llegar a nosotros, durante 18 días entre 2015 y 2017, en lo que se convirtió en la observación de rayos X más larga jamás realizada de esta fuente.

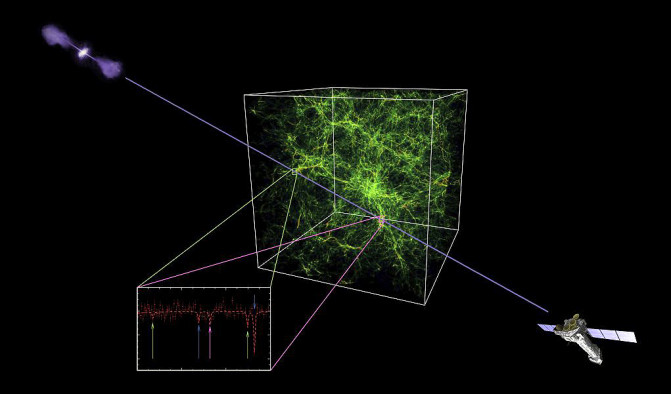

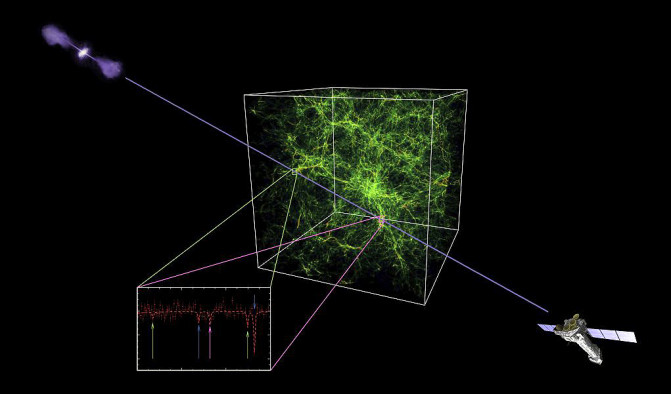

Los astrónomos han utilizado el observatorio espacial XMM-Newton (abajo a la derecha) para encontrar el componente caliente del medio intergaláctico (en verde) observando un lejano cuásar (arriba a la izquierda). / ESA et al.

Comienzan nuevas búsquedas

Este extraordinario resultado supone el comienzo de una nueva búsqueda. Se necesitarán nuevas observaciones de diferentes fuentes astronómicas para confirmar si estos hallazgos son verdaderamente universales, y para investigar más a fondo el estado físico de este material tan largamente buscado.

Fabrizio y sus colegas se plantean ahora estudiar más cuásares con XMM-Newton y Chandra en los próximos años. Sin embargo, para explorar completamente la distribución y las propiedades del llamado medio intergaláctico cálido-caliente, se necesitarán instrumentos más sensibles, como el Telescopio Avanzado para la Astrofísica de Alta Energía (Athena), que la ESA tiene previsto lanzar en 2028.

esa

Las misteriosas energía y materia oscuras constituyen, respectivamente, el 70% y el 25% del universo. El resto, la materia común que compone todo lo que vemos, desde las estrellas y galaxias hasta los planetas y nosotros mismos, representa tan solo un 5%.

Los astrónomos han calculado que ese es el porcentaje de materia ordinaria, formada básicamente por bariones (partículas con tres quarks como los neutrones y protones), a partir de las observaciones del fondo cósmico de microondas, la luz más antigua en la historia del cosmos originada unos 380.000 años después del Big Bang.

Los bariones perdidos estaban en el gas intergaláctico caliente que constituye cerca del 40% de la materia ordinaria

Las observaciones de galaxias muy distantes permiten seguir la evolución de esta materia durante el primer par de miles de millones de años del universo. Sin embargo, justo después más de la mitad desaparece.

"Los bariones perdidos son uno de los mayores misterios de la astrofísica moderna", explica Fabrizio Nicastro, autor principal de un estudio publicado esta semana en Nature y en el que se ofrece una solución al problema. "Sabemos que esta materia debe estar ahí fuera, la vemos en el universo temprano, pero luego la perdemos de vista. ¿Adónde se fue?".

Se estima que las estrellas y el gas interestelar frío –su materia prima– que impregna las galaxias no alcanzan el 10% de la materia común. Sumando el gas caliente difuso de los halos que rodean las galaxias y el todavía más caliente que rellena los cúmulos galácticos –las estructuras cósmicas más grandes que se mantienen unidas por la gravedad–, el porcentaje no llega al 20%.

Esta pequeña proporción no debe sorprender. Las estrellas, galaxias y los cúmulos galácticos se forman en los nudos más densos de la red cósmica, ese entramado de filamentos de materia oscura y ordinaria que se extiende por todo el universo. Aunque estas zonas son densas, también son raras, por lo que no son los mejores sitios para encontrar la mayor parte de la materia cósmica.

En busca de los bariones perdidos

Los astrónomos pensaron entonces que los bariones ‘desaparecidos’ debían estar en los ubicuos filamentos de la red cósmica, donde, sin embargo, la materia es menos densa, y por tanto, más difícil de observar. Utilizando diferentes técnicas, pudieron localizar una buena porción de este material intergaláctico, principalmente sus componentes fríos y cálido (gas a cientos de miles de grados), elevando el porcentaje total a un respetable 60%, pero dejando el misterio general sin resolver. ¿Dónde está el otro 40%?

El descubrimiento se realizó utilizando observaciones de un cuásar distante, una galaxia con un agujero negro supermasivo que devora materia y brilla

Fabrizio y muchos otros astrónomos de todo el mundo han seguido las huellas de los bariones restantes durante casi dos décadas, desde que los observatorios de rayos X como XMM-Newton de la Agencia Espacial Europea (ESA) y Chandra de la NASA se pusieron a disposición de la comunidad científica.

Observando en esa franja del espectro electromagnético, fue cuando pudieron detectar gas intergaláctico realmente caliente, con temperaturas de alrededor de un millón de grados o más, que estaba bloqueando los rayos X emitidos por fuentes aún más distantes.

Para este estudio, los autores utilizaron XMM-Newton para observar un cuásar, una galaxia masiva con un agujero negro supermasivo en su centro que devora activamente materia y brilla intensamente desde los rayos X hasta las ondas de radio. Analizaron este cuásar, cuya luz tarda más de 4.000 millones de años en llegar a nosotros, durante 18 días entre 2015 y 2017, en lo que se convirtió en la observación de rayos X más larga jamás realizada de esta fuente.

Los astrónomos han utilizado el observatorio espacial XMM-Newton (abajo a la derecha) para encontrar el componente caliente del medio intergaláctico (en verde) observando un lejano cuásar (arriba a la izquierda). / ESA et al.

"Después de examinar los datos, logramos encontrar la señal del oxígeno en el gas intergaláctico caliente entre nosotros y el cuásar, en dos puntos diferentes a lo largo de la línea de visión", dice Fabrizio."Esto está sucediendo porque hay enormes reservas de material, incluido oxígeno, depositado allí, y justo en la cantidad que esperábamos, por lo que finalmente podemos completar el hueco que faltaba en el conjunto de bariones del universo".

Comienzan nuevas búsquedas

Este extraordinario resultado supone el comienzo de una nueva búsqueda. Se necesitarán nuevas observaciones de diferentes fuentes astronómicas para confirmar si estos hallazgos son verdaderamente universales, y para investigar más a fondo el estado físico de este material tan largamente buscado.

Fabrizio y sus colegas se plantean ahora estudiar más cuásares con XMM-Newton y Chandra en los próximos años. Sin embargo, para explorar completamente la distribución y las propiedades del llamado medio intergaláctico cálido-caliente, se necesitarán instrumentos más sensibles, como el Telescopio Avanzado para la Astrofísica de Alta Energía (Athena), que la ESA tiene previsto lanzar en 2028.

Para los próximos pasos en este campo se necesitará la mayor sensibilidad del telescopio Athena

"El descubrimiento con XMM-Newton de los bariones desaparecidos es un primer paso emocionante para caracterizar completamente las circunstancias y estructuras en las que se encuentran estas partículas", dice la coautora Jelle Kaastra del Instituto Holandés de Investigación Espacial.

"Para los próximos pasos necesitaremos la sensibilidad mucho mayor de Athena –añade–, que tiene como uno de sus objetivos principales el estudio del medio intergaláctico cálido-caliente, con lo que mejoraremos nuestra comprensión de cómo crecen las estructuras en la historia del universo".

"Estamos orgullosos de que XMM-Newton haya descubierto la señal débil de este evasivo material, escondido en una niebla caliente de un millón de grados que se extiende por el espacio intergaláctico a lo largo de cientos de miles de años luz", destaca Norbert Schartel, uno de los científicos que trabaja con este telescopio en la ESA, quien concluye: "Ahora que sabemos que estos bariones ya no están perdidos, no podemos esperar para estudiarlos con gran detalle".

esa

Hasta hace muy poco pensaban que era imposible, pero por primera vez

un equipo internacional de expertos ha sido capaz de generar y medir un

pulso láser de attosegundo –la trillonésima parte de un segundo– aislado

y con polarización circular. Este logro, publicado en la prestigiosa

revista científica Nature Photonics por el Grupo de Investigación en

Aplicaciones del Láser y Fotónica de la Universidad de Salamanca

(ALF-USAL) (España) en colaboración con científicos de Taiwán y Estados

Unidos, supone tener un control de la luz más preciso y abre nuevas

posibilidades de interactuar con la materia, con potenciales

aplicaciones para campos muy diversos, como el desarrollo de fármacos y

todo tipo de tecnología.

Representación gráfica del pulso láser de attosegundo aislado y con polarización circular. (Foto: DICYT)

“Hemos hecho ingeniería óptica”, explica a DiCYT el investigador del grupo ALF-USAL Carlos Hernández García, “porque la clave ha sido combinar dos técnicas ya existentes para lograr un resultado distinto”. Por una parte, está la generación de pulsos ultracortos (llamados así por su escasa duración, en el orden de los attosegundos) a partir de láseres infrarrojos, conseguida a principios de siglo. Por otra, utilizan también la generación de radiación láser de alta frecuencia con polarización circular, que combina varios haces de luz láser, una técnica desarrollada por los mismos investigadores durante los últimos tres años.

La polarización es la dirección en la que oscilan las ondas

electromagnéticas que componen la luz. Un ejemplo cotidiano de su

importancia son las gafas de sol polarizadas, que filtran reflejos

indeseados de la luz ya que sólo dejan pasar aquella que oscila en una

determinada dirección. Generalmente la polarización es lineal,

horizontal o vertical, aunque “también la dirección del campo puede

describir trayectorias elípticas o circulares al propagarse”.

Cuando se había intentado producir pulsos láser ultracortos con esta

polarizaciones, nunca se había podido conseguir un solo pulso, si no una

cadena de ellos. Haciendo un símil con una cámara de fotos, nunca se

había logrado un solo disparo con un tipo de polarización distinta a la

lineal; para lograrla era necesario emitir una ráfaga, un tren de pulsos

de attosegundo.

No obstante, “la polarización circular no es más que polarización

lineal que en cada instante del tiempo va cambiando de dirección”,

apunta Carlos Hernández García. “Si sabemos producir pulsos con

diferentes polarizaciones lineales, sólo tenemos que retrasar unos con

respecto de otros para lograr la polarización circular. Ese es el

fundamento de esta nueva técnica, que fusiona las otras dos y que nos

permite producir un solo pulso láser con 'polarización a la carta'”.

“Hasta ahora tenías dos opciones: o aislabas pulsos de attosegundo con polarización lineal o tenías trenes de pulsos de attosegundo con polarización circular. Las dos cosas no podían ser, pero por fin hemos logrado aunarlas”, destaca Luis Plaja, líder del grupo ALF-USAL. “La novedad es que unimos dos mundos que hasta ahora eran diferentes”, añade.

Mientras que los investigadores de Taiwán se ocuparon de la parte

experimental, la Universidad de Salamanca se centró en la simulación

teórica que explica el fenómeno. “Conseguimos proponerles la receta de

cómo hacer el experimento para obtener la polarización deseada con el

pulso de attosegundo”, afirma Laura Rego, estudiante de doctorado que ha

tomado parte activa en dichas simulaciones. La colaboración fue muy

estrecha, con constantes intercambios de información.

Aunque se trata de investigación básica, existe un gran interés

por el desarrollo de este campo, porque abre las puertas a muchas

aplicaciones en varias disciplinas científicas. En particular, “hay

materiales denominados dicroicos cuyas propiedades dependen de la

polarización de la luz que interacciona con ellos”, señala Carlos

Hernández García. Es decir, aunque tengan la misma composición química,

se comportan de manera diferente en función del tipo de luz que incide

sobre ellos.

En este caso, cuando la polarización es circular puede ser dextrógira

si gira a la derecha o levógira si gira a la izquierda y esto cambia la

respuesta de ciertas moléculas. “Podemos transmitir giros a los

electrones de una molécula y esto es muy novedoso, es un grado más de

control microscópico que no se podía conseguir hasta ahora con la

polarización lineal”, comenta Luis Plaja.

En este sentido, es muy conocido el caso de las moléculas quirales,

que tienen la misma composición química pero no son exactamente iguales,

sino que una es la imagen en el espejo de la otra, igual que la mano

izquierda y la derecha tienen una simetría diferente. En la historia de

la ciencia esto ha tenido importantes repercusiones, como el caso de la

talidomida, fármaco que hace décadas provocó el nacimiento de bebés con

deformaciones congénitas. El compuesto era una mezcla de moléculas

químicamente iguales, pero que en realidad eran diferentes por su

quiralidad.

Por eso esta investigación puede tener repercusiones para la

investigación química, farmacéutica y para muchos otros campos. “Sabemos

que algunos de esos sistemas van a responder de manera distinta a la

polarización de la luz y podremos estudiarlos y caracterizarlos mejor,

estamos ante una nueva forma de interactuar con la materia”, destacan

los investigadores.

Asimismo, “algunos materiales magnéticos son dicroicos”, así que

contar con pulsos de luz de attosegundo con polarización circular supone

tener una nueva herramienta para analizar y caracterizar sistemas

moleculares y atómicos de todo tipo, así como interactuar con ellos, lo

que tendrá “unas posibilidades tecnológicas que aún se nos escapan”,

afirman los investigadores.

DICYT

En la electrodinámica cuántica (QED) el grupo U(1)em puede ser trivial, igual a SU(1), o no trivial, en cuyo caso las ecuaciones de Maxwell deben incluir un monopolo magnético de Dirac. En la teoría electrodébil (EW) el grupo SU(2)×U(1)Y se rompe en U(1)em gracias al mecanismo de Higgs; el origen de este U(1)em es una combinación del grupo U(1)Y, que puede ser trivial, y del subgrupo U(1) del grupo SU(2), que no es trivial y contiene un monopolo de ‘t Hooft-Polyakov. Por tanto, el grupo U(1)em tras la rotura de simetría electrodébil debe ser no trivial y el modelo estándar debe presentar un monopolo magnético electrodébil, llamado monopolo de Cho-Maison, que es una combinación de los monopolos de Dirac y de ‘t Hooft-Polyakov. En muchos libros se afirma, quizás a la ligera, que la teoría EW no predice ningún monopolo electrodébil porque en la rotura de simetría se puede hacer que U(1)em sea igual a U(1)Y, sin contenido alguno del subgrupo U(1) de SU(2); pero esta elección no es “natural” y no está justificada por ninguna razón física o matemática (salvo eliminar de forma explícita la existencia del monopolo). El monopolo electrodébil de Cho-Maison tiene una carga magnética (4π)/e, en lugar de (2π)/e como el monopolo de Dirac, porque su origen es el subgrupo U(1) de SU(2) que tiene periodo 4π en lugar de 2π. Usando una masa de 125 GeV para el bosón de Higgs, se estima que la masa del monopolo de Cho-Maison es de 3,85 TeV, sin tener en cuenta las correcciones cuánticas, que podrían subir esta masa hasta 6,72 TeV. La búsqueda de este monopolo con masa entre 4 y 7 TeV es la tarea emprendida por el experimento MoEDAL en el LHC que empezará a tomar datos en 2015 y se instalará junto a LHCb. Nos lo cuentan Y. M. Cho, J. L. Pinfold, “Electroweak Monopole Production at the LHC – a Snowmass White Paper,” arXiv:1307.8390, Subm. 31 Jul 2013.

El experimento MoEDAL será el séptimo experimento del LHC y se instalará junto al detector de vértices (VELO) del experimento LHCb, en el punto 8 de cruce de haces. Su objetivo es buscar nueva física que se manifieste como partículas altamente ionizadas, como el monopolo de Cho-Maison (cuya ionización es unas 5000 veces mayor que la producida por un protón moviéndose a la misma velocidad). Se espera que inicie la toma de datos en 2015 cuando el LHC opere en modo colisiones protón-protón a 13 TeV c.m. (o en el mejor caso a 14 TeV).

Los monopolos electrodébiles tienen una gran carga magnética y son absorbidos muy rápido por la parte más interior de los detectores ATLAS y CMS, lo que impide su detección cuando tienen una carga eléctrica o magnética muy alta. El experimento MoEDAL explorará una región más grande de posibles parámetros, de hecho, gran parte del rango de posibles masas del monopolo de Cho-Maison será explorado por MoEDAL.

El monopolo, como el bosón de Higgs, es una predicción del modelo estándar. Aún así, creo que no es exagerado afirmar que su descubrimiento sería más revolucionario.

El experimento MoEDAL será el séptimo experimento del LHC y se instalará junto al detector de vértices (VELO) del experimento LHCb, en el punto 8 de cruce de haces. Su objetivo es buscar nueva física que se manifieste como partículas altamente ionizadas, como el monopolo de Cho-Maison (cuya ionización es unas 5000 veces mayor que la producida por un protón moviéndose a la misma velocidad). Se espera que inicie la toma de datos en 2015 cuando el LHC opere en modo colisiones protón-protón a 13 TeV c.m. (o en el mejor caso a 14 TeV).

Los monopolos electrodébiles tienen una gran carga magnética y son absorbidos muy rápido por la parte más interior de los detectores ATLAS y CMS, lo que impide su detección cuando tienen una carga eléctrica o magnética muy alta. El experimento MoEDAL explorará una región más grande de posibles parámetros, de hecho, gran parte del rango de posibles masas del monopolo de Cho-Maison será explorado por MoEDAL.

El monopolo, como el bosón de Higgs, es una predicción del modelo estándar. Aún así, creo que no es exagerado afirmar que su descubrimiento sería más revolucionario.

Francis (th)E mule Science's News

La noticia “Primeros indicios experimentales de una nueva física más allá del modelo estándar,” Agencia SINC, 31 Jul 2013, ha colmado muchos medios. “Físicos de la Universitat Autònoma de Barcelona (UAB) y del CNRS francés han predicho desviaciones en la probabilidad de una de las desintegraciones del mesón B que han sido detectadas en el acelerador LHC del CERN. Su confirmación será la primera prueba directa de la existencia de la “nueva física” [más allá del] modelo estándar de las partículas.” La predicción de Joaquim Matias y Javier Virto de la UAB, y Sébastien Descotes-Genon (CNRS / Université Paris-Sud) “ha sido confirmada el 19 de julio pasado en la conferencia internacional de física de partículas EPS 2013 de Estocolmo (Suecia); los resultados del análisis de LHCb apuntan a una desviación respecto a la predicción del modelo estándar de 4,5 sigmas.” Se han observado varias “desviaciones que muestran un patrón coherente que permite identificar su origen en una única fuente. Hay que ser prudentes, porque serán necesarios más estudios teóricos y más medidas experimentales para confirmarlo. Uno de los modelos de nueva física que podría explicar estos resultados sería el que postula la existencia de una nueva partícula llamada Zprima, pero podría haber muchos otros modelos compatibles.”

Lo primero, las fuentes. El artículo teórico es Sebastien Descotes-Genon, Joaquim Matias, Javier Virto, “Understanding the B→K*μ+μ- anomaly,” arXiv:1307.5683; la charla que presenta el nuevo resultado es Nicola Serra (LHCb collab.), “Studies of electroweak penguin transitions of b→sμμ,” EPS-HEP Conference, Stockholm, July 2013 [slides]; discute el resultado el propio Joaquim Matias, “Optimizing the basis of B→K* l+l- observables and understanding its tensions,” EPS-HEP Conference, Stockholm, July 2013 [slides]. Un poco de crítica en la blogosfera en Tommaso Dorigo, “A four-sigma evidence of new physics in rare B decays found by LHCb, and its interpretation,” A Quantum Diaries Survivor, July 24, 2013, y en Lubos Motl, “LHCb: 3- or 4-sigma excess of B-mesons’ muon decays,” The Reference Frame, Jul 25, 2013.

Los datos de ATLAS, CMS y LHCb indican que las desintegraciones de los mesones B se comportan como predice el modelo estándar. Sin embargo, en el análisis de un canal concreto de desintegración se pueden introducir múltiples parámetros (observables). Las reglas básicas de la estadística dicen que si se introducen muchos parámetros aparecerán desviaciones (en unos parámetros por exceso y en otros por defecto) incluso cuando el resultado combinado se ajuste muy bien a los datos.

En la desintegración a cuatro cuerpos B→K*μμ, con K*→Kπ, se puede introducir una plétora de observables (la palabra “plétora” no es una exageración mía, aparece en la primera frase del artículo arXiv:1307.5683). Sin entrar en detalles técnicos, Descotes-Genon, Matias y Virto introducen 8 observables llamados P1, P2, P4′, P5′, P6′, P8′, AFB y dΓ/dq² (de hecho, hay muchas otras posibilidades, como usar P3 en lugar de P8′, con más y con menos parámetros). Al analizar estos parámetros por separado con 1/fb datos de colisiones a 7 TeV c.m. obtenidas en 2011 en el experimento LHCb (en ATLAS y CMS es muy difícil hacer este análisis), algunos de ellos muestran grandes desviaciones respecto a las predicciones del modelo estándar (de hasta 4,5 sigmas locales). Todavía es pronto para gritar a los cuatro vientos el descubrimiento de “nueva física” y habrá que confirmar estas desviaciones con el análisis de los 2 /fb de datos de colisiones a 8 TeV c.m. obtenidas en 2012 en el experimento LHCb. Aún resultando pesado, quiero destacar que unas desviaciones son por exceso y otras son por defecto, pero se compensan y el resultado combinado es consistente con el modelo estándar.

¿Qué valor tiene un análisis por separado de ocho parámetros de una desintegración consistente con el modelo estándar? En opinión de Descotes-Genon et al., una primera señal de “nueva física” más allá del modelo estándar podría estar oculta en las desviaciones de varios parámetros si muestran un cierto patrón regular y no son debidas al azar. Estas desviaciones de varios parámetros consistentes entre sí podrían mostrar una primera señal de “nueva física” incluso cuando está oculta en el análisis combinado de la desintegración. Por supuesto, una desviación de un sólo parámetro no es suficiente, de hecho, si fuera muy grande, el resultado combinado debería mostrar dicha desviación. Lo importante es que “haya desviaciones que muestran un patrón coherente que permite identificar su origen en una única fuente.”

¿Qué desviaciones se han observado en LHCb? No hay desviación en P1 y P4′ (aunque tienen mucho error experimental) y hay desviaciones muy pequeñas en P6′ y P8′ respecto al modelo estándar. Hay una desviación por defecto en P2 con 2,9 y 1,7 sigmas en los bins segundo y tercero, resp., que viene acompañada de una desviación en AFB. Lo más llamativo (motivo de la noticia en muchos medios) es una gran desviación por exceso en P5′ con 4,0 y 1,6 sigmas en los bins tercero y segundo, resp. (ver la parte izquierda de la figura que abre esta entrada). En general todas estas desviaciones se pueden entender como que alguno de los dos parámetros de “nueva física” llamados δC7 y δC9 sea negativo (o que lo sean los dos), en lugar de ser nulos (como predice el modelo estándar); en concreto, el mejor ajuste a 1 sigma requiere δC7∈[-0,04, -0,01] y δC9∈[-1,2, -0,5].

En resumen, conforme se acumulen datos en los experimentos del LHC la búsqueda de “nueva física” se hará mucho más refinada y los análisis multiparamétricos serán bastante habituales, pero por ahora hay pocas colisiones analizadas, la señal observada es poco confiable y la interpretación del nuevo resultado que aparece en muchas noticias está sesgada por el intenso deseo de encontrar señales de “nueva física” hasta debajo de las piedras en las que está apoyado el LHC.

Por supuesto, cuando se analice estos parámetros con los 3 /fb de colisiones en LHCb acumuladas en 2011 y 2012, podrás leer una nueva entrada en este blog sobre este asunto. Espero equivocarme, pero creo que algunas de estas desviaciones desaparecerán.

Lo primero, las fuentes. El artículo teórico es Sebastien Descotes-Genon, Joaquim Matias, Javier Virto, “Understanding the B→K*μ+μ- anomaly,” arXiv:1307.5683; la charla que presenta el nuevo resultado es Nicola Serra (LHCb collab.), “Studies of electroweak penguin transitions of b→sμμ,” EPS-HEP Conference, Stockholm, July 2013 [slides]; discute el resultado el propio Joaquim Matias, “Optimizing the basis of B→K* l+l- observables and understanding its tensions,” EPS-HEP Conference, Stockholm, July 2013 [slides]. Un poco de crítica en la blogosfera en Tommaso Dorigo, “A four-sigma evidence of new physics in rare B decays found by LHCb, and its interpretation,” A Quantum Diaries Survivor, July 24, 2013, y en Lubos Motl, “LHCb: 3- or 4-sigma excess of B-mesons’ muon decays,” The Reference Frame, Jul 25, 2013.

Los datos de ATLAS, CMS y LHCb indican que las desintegraciones de los mesones B se comportan como predice el modelo estándar. Sin embargo, en el análisis de un canal concreto de desintegración se pueden introducir múltiples parámetros (observables). Las reglas básicas de la estadística dicen que si se introducen muchos parámetros aparecerán desviaciones (en unos parámetros por exceso y en otros por defecto) incluso cuando el resultado combinado se ajuste muy bien a los datos.

En la desintegración a cuatro cuerpos B→K*μμ, con K*→Kπ, se puede introducir una plétora de observables (la palabra “plétora” no es una exageración mía, aparece en la primera frase del artículo arXiv:1307.5683). Sin entrar en detalles técnicos, Descotes-Genon, Matias y Virto introducen 8 observables llamados P1, P2, P4′, P5′, P6′, P8′, AFB y dΓ/dq² (de hecho, hay muchas otras posibilidades, como usar P3 en lugar de P8′, con más y con menos parámetros). Al analizar estos parámetros por separado con 1/fb datos de colisiones a 7 TeV c.m. obtenidas en 2011 en el experimento LHCb (en ATLAS y CMS es muy difícil hacer este análisis), algunos de ellos muestran grandes desviaciones respecto a las predicciones del modelo estándar (de hasta 4,5 sigmas locales). Todavía es pronto para gritar a los cuatro vientos el descubrimiento de “nueva física” y habrá que confirmar estas desviaciones con el análisis de los 2 /fb de datos de colisiones a 8 TeV c.m. obtenidas en 2012 en el experimento LHCb. Aún resultando pesado, quiero destacar que unas desviaciones son por exceso y otras son por defecto, pero se compensan y el resultado combinado es consistente con el modelo estándar.

¿Qué valor tiene un análisis por separado de ocho parámetros de una desintegración consistente con el modelo estándar? En opinión de Descotes-Genon et al., una primera señal de “nueva física” más allá del modelo estándar podría estar oculta en las desviaciones de varios parámetros si muestran un cierto patrón regular y no son debidas al azar. Estas desviaciones de varios parámetros consistentes entre sí podrían mostrar una primera señal de “nueva física” incluso cuando está oculta en el análisis combinado de la desintegración. Por supuesto, una desviación de un sólo parámetro no es suficiente, de hecho, si fuera muy grande, el resultado combinado debería mostrar dicha desviación. Lo importante es que “haya desviaciones que muestran un patrón coherente que permite identificar su origen en una única fuente.”

¿Qué desviaciones se han observado en LHCb? No hay desviación en P1 y P4′ (aunque tienen mucho error experimental) y hay desviaciones muy pequeñas en P6′ y P8′ respecto al modelo estándar. Hay una desviación por defecto en P2 con 2,9 y 1,7 sigmas en los bins segundo y tercero, resp., que viene acompañada de una desviación en AFB. Lo más llamativo (motivo de la noticia en muchos medios) es una gran desviación por exceso en P5′ con 4,0 y 1,6 sigmas en los bins tercero y segundo, resp. (ver la parte izquierda de la figura que abre esta entrada). En general todas estas desviaciones se pueden entender como que alguno de los dos parámetros de “nueva física” llamados δC7 y δC9 sea negativo (o que lo sean los dos), en lugar de ser nulos (como predice el modelo estándar); en concreto, el mejor ajuste a 1 sigma requiere δC7∈[-0,04, -0,01] y δC9∈[-1,2, -0,5].

En resumen, conforme se acumulen datos en los experimentos del LHC la búsqueda de “nueva física” se hará mucho más refinada y los análisis multiparamétricos serán bastante habituales, pero por ahora hay pocas colisiones analizadas, la señal observada es poco confiable y la interpretación del nuevo resultado que aparece en muchas noticias está sesgada por el intenso deseo de encontrar señales de “nueva física” hasta debajo de las piedras en las que está apoyado el LHC.

Por supuesto, cuando se analice estos parámetros con los 3 /fb de colisiones en LHCb acumuladas en 2011 y 2012, podrás leer una nueva entrada en este blog sobre este asunto. Espero equivocarme, pero creo que algunas de estas desviaciones desaparecerán.

Francis (th)E mule Science's News

El experimento PAMELA, instalado en un satélite, ha medido el flujo de positrones en los rayos cósmicos con energía de hasta 300 GeV. Durante el mínimo del último ciclo solar entre julio de 2006 y diciembre de 2009 se han observado 24.500 positrones, muchos más de los esperados. Este exceso apunta a una fuente astrofísica (quizás galáctica) que aún se desconoce. ¿Será la materia oscura? Por ahora nadie lo sabe, pero todo apunta a otra fuente exótica. El exceso también ha sido observado por AMS-02, en la Estación Espacial Internacional, cuyos datos tienen menor error pero casi coinciden con los nuevos datos publicados por PAMELA. ¿Qué será esa fuente exótica de positrones? Quizás habrá que esperar al telescopio espacial James Webb para descubrir la fuente galáctica de tipo astrofísico responsable de este exceso de positrones. El nuevo artículo técnico es PAMELA Collaboration, “The cosmic-ray positron energy spectrum measured by PAMELA,” arXiv:1308.0133, Subm. 1 Aug 2013.

PAMELA (a Payload for Antimatter Matter Exploration and Lightnuclei Astrophysics) ha medido la fracción entre el flujo de positrones, y el flujo de electrones y positrones, φ(e+) / (φ(e+)+φ(e−)), con energía entre 1,5 y 100 GeV, en los rayos cósmicos que inciden en la tierra. En 2008 ya se publicó la existencia del exceso en los datos de PAMELA [ver aquí y aquí también], que AMS-02 ha confirmado este mismo año [ver aquí y aquí también]. Como muestra esta figura, a comparar los resultados de PAMELA con los de AMS-02 se observa que a baja energía (por debajo de 5 GeV) los resultados de PAMELA son un poco mayores que los AMS-02 (y ambos más bajos que los de otros experimentos, salvo Aesop). La razón es la dinámica del ciclo solar que modula el flujo de partículas de carga positiva en los rayos cósmicos (de origen solar, porque como ya sabrás los rayos cósmicos no tienen por qué tener un origen cosmológico). PAMELA ha tomado datos entre 2006 y 2009, cuando AMS-02 los ha tomado entre 2011 y 2013 (y otros experimentos en otros momentos del ciclo solar).

El gran problema con este exceso de positrones es que no viene acompañado de un exceso de protones. Por ello, si el origen de este exceso es la materia oscura, debe ser muy exótica, como neutralinos de muy alta masa que se desintegran con preferencia en leptones (lo que requiere un ajuste fino en los modelos supersimétricos, en contra de la “naturalidad” de la SUSY). Lo más razonable es que su fuente sea astrofísica; positrones originados en púlsares distribuidos en el halo galáctico que son acelerados por los campos magnéticos de la galaxia [ver aquí, aquí y aquí también]. El problema es que estas fuentes astrofísicas no han sido observadas aún (aunque su existencia no contradice los resultados de los modelos de simulación galáctica). Los próximos años serán muy apasionantes en este campo.

Francis (th)E mule Science's News

En el punto triple del agua (a 0,01 °C de temperatura y 612 pascales de presión) coexisten en equilibro sus tres estados sólido, líquido y gaseoso. El dióxido de vanadio es un sólido que presenta un punto triple a 65 °C en el que coexisten tres fases sólidas, dos aislantes (con estructuras cristalinas monoclínicas, M1 y M2) y una conductora (con estructura tetragonal tipo rutilo, R). Gracias a un dispositivo micromecánico se ha medido con alta precisión el diagrama de fase temperatura versus esfuerzo en tracción de una nanobarra de dióxido de vanadio (VO2). Películas delgadas de óxido de vanadio se utilizan mucho en la industria electrónica y en óptica física como “material inteligente” (porque sus propiedades varían mucho con la temperatura y el voltaje aplicado). La más interesante de las tres fases es M2 ya que no hay ninguna teoría microscópica que explique su estabilidad; el nuevo diagrama de fase guiará los cálculos de la estructura electrónica mediante ordenador, lo que quizás ayude a aclarar este asunto. Existen puntos triples sólidos en la manganita y en niquelatos de tierras raras, aunque aplicar el nuevo método de medida no será fácil pues se requieren nanobarras de muy alta calidad. Nos lo cuenta Douglas Natelson, “Condensed-matter physics: A solid triple point,” Nature 500: 408–409, 22 Aug 2013, que se hace eco del artículo técnico de Jae Hyung Park et al., “Measurement of a solid-state triple point at the metal–insulator transition in VO2,” Nature 500: 431–434, 22 Aug 2013.

En las tres fases del dióxido de vanadio hay dos conjuntos de cadenas paralelas de átomos de vanadio (en negro en la figura), cada uno rodeado de seis átomos de oxígeno (no mostrados en la figura) que forman un octaedro distorsionado. En la fase R (de tipo rutilo), a alta temperatura, todas las cadenas son rectas y periódicas, mientras que en la fase M1 (monoclínica) todos los átomos de vanadio forman dímeros. Hay otras dos fases aislantes; la fase M2 (monoclínica) en la que sólo una de las cadenas de átomos de vanadio forma dímeros y la fase T (triclínica) intermedia entre M1 y M2. Las dos fases monoclínicas tienen propiedades aislantes similares. La mayor diferencia en la celda unidad entre las tres fases R, M1 y M2 es la distancia interatómica en el eje longitudinal de las cadenas (eje c de la estructura tipo rutilo), en concreto c(R) = 5,700 Å, c(M1) = 5,755 Å y c(M2) = 5,797 Å.

Para estudiar el punto triple del dióxido de vanadio se comprime una nanobarra en la dirección del eje de las cadenas de átomos de vanadio mientras se cambia la temperatura. El punto triple ocurre a una temperatura de 65,0 ± 0,1 °C y se observa gracias a una discontinuidad en el diagrama plano que relaciona la longitud de la nanobarra y la temperatura.

En mi opinión, lo más interesante de este trabajo es que nos recuerda que aún muchas propiedades electrónicas de los materiales sencillos que no sabemos calcular de forma teórica. Se espera que el intento de reproducir mediante simulaciones por ordenador el diagrama de punto triple obtenido en los experimentos permitirá desarrollar una teoría microscópica que explique las transiciones M1-M2 y R-M2, lo que a su vez ayudará a diseñar mejores películas de “materiales inteligentes” para aplicaciones prácticas.

Francis (th)E mule Science's News

Científicos del LHC convierten en sonido la conversión de partículas de materia en sus contrarias

Los científicos del LHC del CERN observaron recientemente cómo dos partículas eran capaces de transformarse de materia en antimateria y viceversa. Ahora, los investigadores han convertido esos datos en sonido, de modo que podamos escuchar la música de la antimateria.

Para cada partícula fundamental, existe su antipartícula correspondiente. Las partículas de antimateria comparten la misma masa que sus contrarias de materia, pero su carga eléctrica es opuesta. Aunque la mayoría de las partículas existen como materia o antimateria, algunas de ellas pueden cambiar entre las dos.

B0 y B0S son esas partículas. Oscilan entre la materia y la antimateria millones de millones de veces por segundo. Si esa frecuencia se convirtiera directamente en el tono de una nota musical, sería demasiado alta para el oído humano. Los físicos han ralentizado la frecuencia millones de veces para que podamos disfrutar de la oscilación como sonido detectable.

En el vídeo sobre estas líneas, un cuadro azul se mueve de izquierda a derecha en la pantalla, representando el área de la gráfica que se puede escuchar. Al principio solo se escucha ruido blanco, fluctuaciones de fondo al azar de partículas en el detector LHCb. Pero los dos picos en la gráfica provienen de las partículas de B0 y B0S. Primero se escucha el tono alto de las B0, seguido por el tono de las B0S. Las últimas son oscilaciones experimentalmente más difíciles de observar, por lo que su tono no es tan fuerte.

Desde el CERN recomiendan sentarse, relajarse y disfrutar de la música de las partículas que pasan a la antimateria y vuelven millones de veces por segundo. Es el sonido de la física.

ABC.es

Suscribirse a:

Entradas

(

Atom

)

Viaje a las estrellas

Buscar

Calendario lunar

Lo + visto

Entrada destacada

Labels

Agujero negro

Anecdotas de Newton

Anecdotas y Curiosidades

Articulos

Articulos Astrofisica

Articulos Astronautica

Articulos Astronomia

Articulos Astronomos

Articulos Cometas

Articulos Cosmologia

Articulos Estrellas

Articulos Fisica

Articulos Galaxias

Articulos planetas

Articulos Planetas Marte

Articulos Satelites

Asteroides

Astrobiologia

Astrofisica

Astronautica

Astronomia

Boson de Higgs

Cometas

Cosmologia

Curiosity

Eclipses

Einstein

Estrellas

Europa

Exoplanetas

Fisica

Física

Fisica cuantica

Física de partículas

Fondo Cosmico de Microondas

Gaia

Galaxias

Historia

Inflacion

Io

Jupiter

LHC

Luna

Marte

Materia oscura

Meteorito Chelyabinsk

Nebulosas

Noticias

Ondas gravitacionales

Opportunity

Planetas

Pluton

Por que...

Satelites

Saturno

Sol

Teoria de Cuerdas

Tierra

Titan

Voyager